Artificial Intelligence

Was ist ein Sprachmodell? – Eine Einführung

Erfahren Sie, was ein Sprachmodell ist, seine Funktionsweise und Anwendungen in der modernen Technologie. Entdecken Sie die Herausforderungen und Zukunftsperspektiven dieser faszinierenden Technologie.

In der heutigen digitalen Welt sind Sprachmodelle zu einem unverzichtbaren Bestandteil der Technologie geworden. Doch was genau verbirgt sich hinter dem Begriff “Sprachmodell”?

In diesem Artikel werden wir diese Frage umfassend beantworten, indem wir die Definition, Funktionsweise, Typen und Anwendungen von Sprachmodellen untersuchen.

Was ist ein Sprachmodell?

Ein Sprachmodell ist im Grunde genommen ein mathematisches Modell, das darauf abzielt, die Sequenz von Elementen in einem Text vorherzusagen – sei es Buchstaben oder Wörter.

Diese Modelle spielen eine zentrale Rolle in der Computerlinguistik und finden Anwendung in Bereichen wie Textgenerierung, maschineller Übersetzung und Spracherkennung.

Sie sind im Wesentlichen Wahrscheinlichkeitsverteilungen über Wortsequenzen und ermöglichen es ihnen, die Wahrscheinlichkeit bestimmter Wortfolgen vorherzusagen.

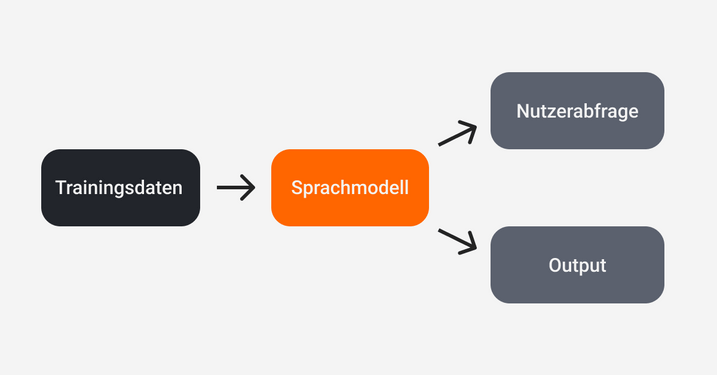

Vereinfachte Funktionsweise eines Sprachmodells.

Typen von Sprachmodellen

Es gibt verschiedene Arten von Sprachmodellen, die jeweils unterschiedliche Mechanismen verwenden:

-

Stochastische Sprachmodelle: Diese Modelle behandeln Wörter als Zufallsvariablen in einer Sequenz und verwenden oft Markov-Annahmen, bei denen nur eine begrenzte Anzahl vorangehender Elemente berücksichtigt wird.

-

Neuronale Sprachmodelle: Diese Modelle nutzen künstliche neuronale Netze zur Berechnung von Wahrscheinlichkeiten und schätzen Parameter wie Gewichte anstelle von Wahrscheinlichkeiten direkt ab.

-

Große Sprachmodelle (LLMs): Modelle wie GPT (Generative Pre-trained Transformer) und BERT (Bidirectional Encoder Representations from Transformers) sind in der Lage, komplexe Texte zu verstehen und zu generieren und nutzen Milliarden von Parametern.

Was sind Transformermodelle?

Transformer-Modelle sind eine Art von neuronalen Netzwerken, die speziell für die Verarbeitung von Sequenzdaten entwickelt wurden. Sie wurden erstmals 2017 in einem bahnbrechenden Papier mit dem Titel “Attention is All You Need” vorgestellt. Im Gegensatz zu traditionellen rekurrenten neuronalen Netzen (RNNs) nutzen Transformermodelle Mechanismen der Selbstaufmerksamkeit und des Feedforward-Netzwerks, um effizienter zu arbeiten.

Funktionsweise von Transformermodellen

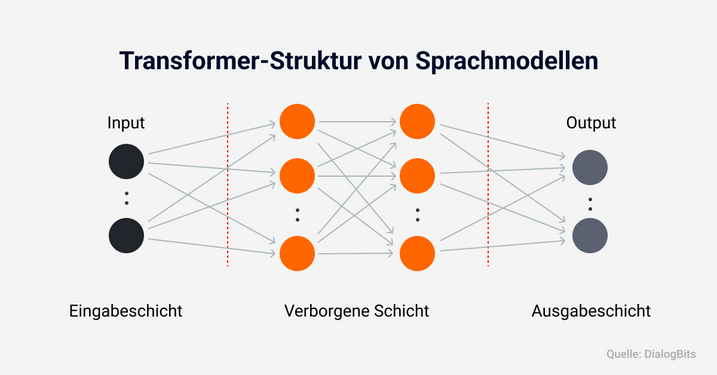

Die Funktionsweise von Transformer-Modellen basiert auf zwei Hauptkomponenten: Selbstaufmerksamkeit und Feedforward-Schichten:

-

Selbstaufmerksamkeit: Dieser Mechanismus ermöglicht es dem Modell, den Zusammenhang zwischen verschiedenen Positionen in einer Eingabesequenz zu erkennen. Jedes Wort in einem Satz kann so seine Beziehung zu anderen Wörtern bewerten.

-

Feedforward-Schichten: Nach der Anwendung der Selbstaufmerksamkeit durchläuft die Ausgabe mehrere Schichten eines Feedforward-Netzwerks, das unabhängig an jeder Position arbeitet.

-

Encoder-Decoder-Struktur: Transformers bestehen aus einem Encoder, der Eingabesequenzen verarbeitet, und einem Decoder, der Ausgabesequenzen generiert. Diese Struktur ist besonders nützlich für Aufgaben wie maschinelle Übersetzung.

Transformermodell.

Anwendungen von Sprachmodellen

Sprachmodelle erleichtern die Kommunikation zwischen Mensch und Computer erheblich. Sie ermöglichen Aufgaben wie das Verstehen von Texten, Spracherkennung und Textgenerierung. Häufige Anwendungen umfassen:

-

Chatbots für Kundenservice: Automatisierte Systeme können Kundenanfragen effizient bearbeiten.

-

Übersetzungstools: Diese helfen bei der Überwindung von Sprachbarrieren durch präzise Übersetzungen.

-

Textgenerierungsanwendungen: Von kreativen Schreibassistenten bis hin zu automatisierten Berichtserstellungen.

Fazit

Sprachmodelle haben sich als wesentliche Werkzeuge in der modernen Technologie etabliert. Sie bieten zahlreiche Anwendungen, stehen jedoch auch vor Herausforderungen hinsichtlich Genauigkeit und Sicherheit.

Mit kontinuierlichen Fortschritten versprechen sie eine spannende Zukunft voller Möglichkeiten für Innovationen im Bereich der natürlichen Sprache.